谷歌前CEO埃里克·施密特:“非人类智能”崛起将重塑全球格局

5 月 17 日消息,谷歌前 CEO 兼董事长埃里克 · 施密特最近接受技术专家比拉瓦尔 · 西杜专访,声称 " 非人类智能 " 的到来将彻底改变世界格局,而当前社会对于人工智能颠覆性潜力的认知依然严重不足。

施密特指出,AI 技术正以惊人的速度突破边界,催生出一批能够独立完成复杂任务的自主系统,其能力已远超公众的普遍预期。从 AlphaGo 在围棋比赛中的 " 神之一手 ",到当下 AI 在规划、推理和科研中的深度应用,这场技术革命正迅速由 " 语言生成 " 迈向 " 战略决策 "。

在访谈中,施密特深入剖析了 AI 所带来的巨大机遇、面临的深层挑战和系统性风险,并直言当前全球治理体系尚未为这一转变做好准备。他强调,能源与算力的瓶颈、开源模型的潜在滥用、安全边界的模糊不清,都可能成为 AI 发展的关键障碍。

施密特警告,AI 时代的到来并非遥不可及的未来,而是正在发生的现实。在这样的背景下,每个人——无论是技术人员、企业家、教师还是政府决策者——都必须主动拥抱这项技术,否则将被时代无情淘汰。

" 这不是一场短跑,而是一场马拉松," 他提醒道," 我们正站在人类历史上最重要的一次技术变革门前,必须小心行事,确保不在关键时刻失误。"

以下为施密特最新专访全文:

01 " 非人类智能 " 的觉醒时刻

问:你曾说过,非人类智能的到来是一件意义极其重大的事件。这张拍摄于 2016 年的照片,似乎记录了地球正在悄然发生的剧变,只是当时许多人还没有意识到。你当时看到了什么,是我们其他人所忽视的?

施密特:2016 年时,我们也还不清楚之后会发生什么,但已经开始意识到,这些新算法蕴藏着巨大的力量。

那一年,围棋比赛中的第二局,AI 下出了一步前所未有的棋。这一招在拥有 2500 年历史的围棋中从未出现过,震惊了整个围棋界的顶尖高手——这些人不仅技艺高超,也是直觉与数学天赋兼备的佼佼者。

AlphaGo 的设计原则,是始终维持超过 50% 的胜率,因此它会选择最优解。这一招正是经过严密计算后得出的选择,表明它在实战中发现了人类未曾触及的全新策略。

当时,我和亨利 · 基辛格(前美国国务卿)、克雷格 · 蒙迪(微软前首席研究和战略官)开始思考:这意味着什么?为什么计算机会想出人类几千年来从未想到的解法?围棋可是一项亿万人参与过的古老游戏!从那个时候开始,我们决定联手写两本书。我认为,这便是 AI 革命真正的起点。

问:如今,AI 成为人人热议的话题,尤其在 TED 大会上尤为突出。但你却认为 AI 的潜力被低估了,为什么?

施密特:多数人提到 AI 时,想到的都是 ChatGPT。对很多人来说,这是他们首次真正体验到 AI 的 " 震撼时刻 " ——它能写作,虽然有时会出错,但语言表达能力令人惊艳。我当时的反应也是如此,周围的朋友们也一样。

但那已经是两年前的事情了。自那之后,我们在强化学习方面取得了巨大突破——这正是 AlphaGo 所开启的路线——让我们能够真正实现 " 规划能力 "。举例来说,像 OpenAI 的 o3 模型或 DeepSeek R1 模型,它们已经展现出在前后推演、反复尝试和策略调整方面的惊人能力。

我自己收购了一家火箭公司,因为我对这个领域并不熟悉,但我希望成为专家。我使用 AI 系统进行深入研究,它们能在 15 分钟内生成一篇具有深度的技术论文。你要知道,短短 15 分钟里所调用的超级计算资源何其庞大!这意味着我们已经从 " 语言处理 " 进化到了 " 生物序列生成 " 等更复杂领域,现在我们正迈入 " 规划与策略 " 阶段。

最终目标是:让计算机全面接管商业流程。一个智能体负责处理某项任务,另一个负责另一项任务,然后它们之间通过自然语言(通常是英语)进行交流与协作。

02 AI 三大核心挑战:电力、数据、知识边界

问:说到这些系统所需的庞大算力,我们来谈谈 " 扩展性 " 问题。我常觉得 AI 系统就像贪吃蛇,不断吞噬我们提供的数据和算力。它们几乎已经 " 吃光了 " 网络上的公开数据,而我们似乎也无法赶上它们对数据中心的需求增长速度。你怎么看待这些瓶颈?我们该如何在它们成为发展限制之前提前应对?

施密特:最大的问题是能源限制。我几天前在美国国会作证时指出:未来美国还需要新增 90 吉瓦的电力。我的建议是可以考虑加拿大——那里民众友善、水电资源充沛。你要明白,90 吉瓦相当于建造 90 座核电站,而美国目前一座都没有在建。这些能源从哪里来?这是一个国家层级的重大议题。

相比之下,中东地区正在建设规模达 5 至 10 吉瓦的数据中心,印度也在规划 10 吉瓦级别的项目。你可以这样理解吉瓦的量级:一个数据中心可能就需要支撑一座城市的用电需求。

也许有人会说,算法会越来越高效,从而降低能耗。的确,硬件性能在不断提升,但软件总是能将其迅速 " 耗尽 "。尤其是在涉及 " 规划 " 任务的系统中,当前算法依赖大量的尝试与反馈机制,计算密集度极高。Andreessen Horowitz 的研究显示:在进行此类复杂规划任务时,AI 所需的算力至少是现在的 100 倍,甚至是 1000 倍。

当然,技术路径也在不断演进。从深度学习到强化学习,再到 " 测试时计算 "(test-time compute)—— AI 不仅要规划,还要在执行过程中持续学习。这正是当前 AI 对算力需求达到峰值的原因。

接下来有三个核心挑战:

1. 电力与硬件瓶颈:AI 发展受限于基础设施,尤其是清洁、稳定的电力供应。

2. 数据枯竭:我们已经消耗了几乎所有公开数据,下一阶段必须依靠 AI 生成数据。

3. 知识的边界:这是最根本的问题。我们目前所构建的所有 AI 系统,几乎都建立在人类既有知识之上。那么,我们该如何超越已有的知识,创造真正的 " 新知 "?

以爱因斯坦为例,他的伟大发现不是从基础知识中直接推导出来的,而是在跨学科观察中,发现了两种看似无关领域的共同模式,然后迁移方法、推演理论,最终构建出全新框架。

而当前的 AI 系统尚未具备这种能力。如果我们能攻克这个问题,也就是技术上所说的 " 目标的非平稳性 " ——即环境与规则在不断变化的情境下进行学习与适应,那么 AI 将开启一个全新的时代。这也意味着我们需要更多的数据中心,并将由此打开科学与思想的全新边界,这将是一场真正的革命。

03 AI 三大风险,应建立 " 断电 " 机制

问:" 自主性 " 是当前 AI 领域最受关注的话题之一。不久前,AI 教父约书亚 · 本吉奥发表了一个引人注目的演讲,呼吁暂停开发具备自主意识能力的 AI 系统。然而,这恰恰是各大 AI 实验室正在积极推进的方向。你对此有何看法?

施密特:本吉奥是这项技术的开创者之一,也是我多年的好友。我们就这个问题讨论过很多次,他的担忧是完全合理的。但关键问题不是 " 他的担忧是否成立 ",而是 " 我们应如何应对 "。

我们先从 " 智能体 " 这个概念谈起。假设在座的各位都是一个智能体,你们接收输入(例如英语),产生输出(也是英语),并拥有记忆能力,就像人类一样。如果有一天,其中某个智能体突然决定放弃使用人类语言,转而创造一种我们无法理解的机器语言,那么我们就完全失去了对它的理解与掌控。

在这种情况下,我们唯一能做的就是 " 断电 "。因为我们无法预测它的行为——它可能在做坏事,也可能取得了惊人成就,但我们毫无所知。因此,可追踪性与可观察性是最基本的前提。

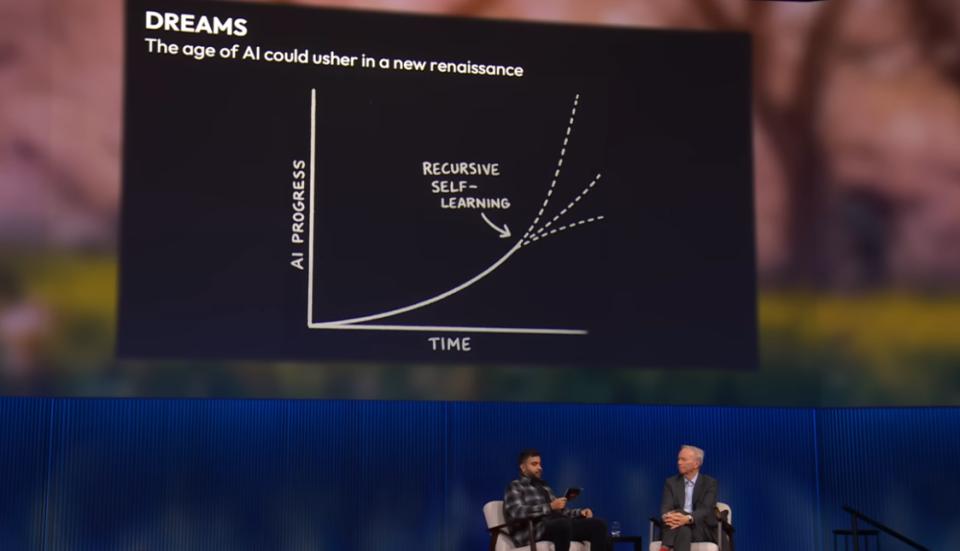

目前整个行业普遍达成一致:当出现以下几种情况时,应触发 " 断电 " 机制:

● 递归自我改进:即 AI 自主学习并持续优化自身,但这个过程脱离了人类控制;

● 获得武器控制权:AI 一旦能直接操控军事系统,后果不堪设想;

● 自我复制或扩展:若 AI 系统试图在未经授权的情况下自我扩散,必须立即中止。

所以,我认为本吉奥的警示是善意的,但在一个全球科技竞赛日益激烈的背景下,简单地呼吁 " 暂停开发 " 并不现实。我们真正需要的,是建立清晰、可执行的护栏机制与制度化监管,而非一刀切地停止技术进步。

04 AI" 相互威慑 " 时代来临?

问:我们接下来进入 AI 最具争议的话题之一——它的 " 多重用途 " 性质。AI 既可以用于民用,也可以被部署于军事系统。那么我们应如何处理这种技术所引发的道德困境,以及人类在使用 AI 时的责任问题?

施密特:在许多领域,其实我们已经有较为成熟的责任制度。例如,我参与过不少与军事相关的项目。美国军方有一项明确的政策——国防部 3000.09 号指令,也就是著名的 " 人在回路 "(meaningful human control)原则,规定任何武器系统都必须在人类有效控制之下。这条底线不容突破,我完全赞成。

但未来最具决定性的,将是中国和美国在 AI 领域的竞争格局。我可以举几个具体例子说明:

我们这个行业非常依赖中国的一些关键部件和材料——听起来或许不起眼,比如胶水、封装材料等,但这些零部件对 AI 硬件至关重要。如果中国决定切断这些材料的出口,后果将十分严重。

与此同时,美国正限制中国获得高端 AI 芯片,这引起了中方强烈反弹。基辛格博士曾邀请我与克雷格 · 蒙迪一起参与对中方的 " 二轨外交 "(Track II Dialogue),我们与中国的技术专家有过深入沟通。他们最关切的问题就是芯片封锁。例如,中国的 DeepSeek 模型非常出色,它通过优化算法在算力有限的情况下仍实现了惊人的效果。由于他们采用开源方式,美国研究人员立刻可以使用其成果,并迅速将其融入本国 AI 体系。

当前的局势非常微妙。美国开发的 AI 系统大多是封闭式、受控式系统,而中国则可能在开源 AI 领域确立全球领导地位。如果这种局面持续下去,开源技术将在全球范围内快速扩散,这在网络安全、AI 生物合成等高敏领域可能带来极大的安全风险。

更严重的是,它可能带来类似 " 核威慑 " 的后果。基辛格博士是 " 相互确保毁灭 " 战略理论的缔造者之一,他深知技术威慑的逻辑。而当前 AI 领域的竞争,正朝着这种方向演变。

我来举一个例子说明这个问题的严重性:你是 " 好人 ",我是假设中的 " 坏人 "。你在 AI 超级智能的竞赛中领先我 6 个月。虽然时间不长,但这不是线性差距,而是典型的网络效应型优势。以 OpenAI 或 Gemini 为例,它们拥有上千名工程师,目前正在训练出 100 万个 AI 软件工程师。这些 AI 工程师不需要休息、不请病假,效率远高于人类。随着技术临近超级智能,发展速度会呈指数级爆炸增长。

一旦你率先实现超级智能,我将永远无法追赶,而你所掌握的 AI 能力足以重塑世界秩序,甚至摧毁我的体系。从 " 坏人 " 的角度看,我必须阻止你:我尝试盗取你的模型——失败;我试图渗透你的组织——防护严密;我最终只剩一个选项:摧毁你掌控的数据中心。

这听上去很疯狂,但现实中,拥有核武器的国家已经在认真讨论类似情景。一些理性、冷静的战略人士正在说:" 我们唯一的机会,就是先发制人。" 因为谁先掌握超级智能,谁就能主导全球经济、创新、治理与监控体系。

而我们的问题是——全社会尚未开始这场对话。外交官、政策制定者都还未做好准备,但这场 AI 主导的战略博弈已迫在眉睫,可能就在五年内全面爆发。

我们现在还有时间,必须立即展开这场关键讨论。

问:如果确实存在这种危险的 " 对峙 " 或 " 相互毁灭 " 的潜在风险,你却仍然主张美国应当拥抱开源 AI。尤其是在中国通过极低算力就开发出 DeepSeek 这类系统的背景下,开源是否等同于主动交出核心能力,加速对手的崛起?

施密特:这是一个极其棘手的问题,我们称之为 " 恶性难题(malignant dilemma)"。我们整个科技产业和科研体系——包括大学、企业、实验室和开发者社区——都建立在开放研究和开源协作的基础上。谷歌早期的许多核心技术正是从开源中孕育出来的,一部分至今仍是开源的,另一部分则成为了专有技术。这种开放与专有并存的策略,本身是合理的。

但当开源模型的能力变得强大到足以被恶意行为者滥用,比如被类似奥萨马 · 本 · 拉登那样的人掌握,我们该怎么办?而现实是,世界上确实存在不少这样的人。对此,我们还没有明确答案。

目前业内的共识是:开源 AI 模型虽然还未达到真正对国家安全或全球秩序构成实质威胁的程度,但它们正沿着那条轨迹快速前进。所以,未来中美两国以及两国的科技企业将做出哪些关键决策,将在很大程度上决定整个人类社会的方向。

我之所以特别强调中美,是因为只有这两个国家 " 疯狂 " 到愿意为 AI 愿景投入数百亿美元的真金白银。欧洲虽然有强烈意愿参与,但其金融结构不足以支撑这场全球级竞赛;印度、中东虽然积极布局,也面临同样的资源问题。这注定是一场决定未来格局的双边博弈。

我们前面提到过 AI 领域可能出现的 " 先发制人 " 路径,虽然听起来极端,但这类讨论已经在核国家之间悄然展开。这就要求我们,现在就必须启动关于 AI 治理、安全、透明性与合作机制的全球性对话。

05 拥抱希望:AI 能否彻底改变医疗、教育与科学?

问:在我们努力治理 AI 系统、防止其滥用的同时,很多治理手段本身却开始看起来像是《一九八四》式的极权社会。比如 " 人类身份验证 "、大规模内容审核等措施。你怎么看待这种 " 治理与自由 " 的矛盾?我们是否有可能在防止技术被滥用的过程中,反而建立了终极监控国家?

施密特:我们必须始终坚守核心价值观,尤其是人类自由。我个人高度重视个人自由。一个出于善意的工程师,也可能无意间造出一个效率极高、但剥夺人类自由的系统。因此,我们需要在系统设计之初就内嵌对自由的保护机制。

很多时候,这其实并非技术问题,而是商业或政策选择。确实,你可以建立一个监控国家,也可以构建一个以技术促进自由的社会结构。你所说的矛盾,之所以变得突出,是因为在今天,操纵信息、制造谎言变得前所未有地容易。因此,确实需要某种形式的 " 身份验证机制 ",来确保信息传播的真实性和责任归属。

但这不意味着必须泄露个人隐私。完全可以通过加密手段证明 " 你是一个人类 ",而无需透露你是谁、你在哪,也无法被用于跨平台追踪。这是技术上完全可行的。

问:在你和基辛格博士合著的《创世纪》一书中,你展现了对 AI 未来的谨慎乐观。当你展望未来,有哪些事物是你真正感到兴奋的?

施密特:随着年纪增长,我身边有很多朋友患上了严重的疾病。这些病能不能治好?我们能不能从根本上根除它们?我认为完全有可能。

我知道一家非营利机构,正在尝试在未来两年内识别出所有人类体内的 " 可作用药物靶点 ",并向全球科研人员开放数据。如果我们知道了靶点,制药产业就可以针对性地开展药物研发。

我还参与了一家初创公司,他们的目标是将三期临床试验的成本降低一个数量级。要知道,正是这些临床试验成本最终推高了药品的市场价格。如果能降低试验成本,我们就能以更低成本、更快速度开发新药。

我也对暗能量与暗物质充满好奇。那背后或许藏着一整套全新的物理学革命。如果我们能理解这些力量,将推动材料科学、交通系统、能源系统的重大飞跃。

再比如教育——为什么不能让每个孩子,从幼儿园起就拥有一个说母语的 AI 导师?这个想法非常诱人,那为什么我们还没有实现呢?唯一可能的解释就是——它没有一个足够有吸引力的经济模式。技术上我们已经能做到这一点。技术其实已经完全成熟了。我们可以用本地语言教授内容,通过游戏化的方式提升学习效果,让每个人都发挥出自己的最佳潜力。

在医疗方面,世界上大多数人要么无法获得医疗服务,要么只能依赖护士或村医在艰苦条件下工作。为什么不能为他们配备一个说本地语言、提供精准诊断和治疗建议的 AI 医生助手?这将极大提升基层医疗质量。

我们还面临数字孤岛化的问题。尽管互联网连接了我们,但数字工具却在某种程度上加剧了孤独感。我们渴望被理解、被连接,但工具设计却常常反其道而行。我们必须改变这种趋势。而且,这些问题是可以解决的——它们不需要新的物理理论,不需要重大发现,我们只需要下定决心去做。

所以,当我展望未来,我想明确一点:人工智能,尤其是通用人工智能(AGI)和未来可能实现的超级智能,将会是过去五百年,甚至一千年来,人类社会最重要的事件。而它正在我们的有生之年成为现实。我们必须小心,不要搞砸了这个机会。

06 这是一场马拉松,不是短跑

问:假设我们真的没有搞砸,假设我们成功进入一个 " 极度富足 " 的时代,达到了递归自我提升的临界点,AI 系统承担了几乎所有经济性工作任务。在你设想的未来,人类会做什么?我们是否真的会在沙滩上悠闲地喝着菠萝鸡尾酒,搞点兴趣爱好?

施密特:你这个科技自由主义者,肯定支持全民基本收入(UBI)吧?但现实是,即便我们正处在一场前所未有的科技革命之中,人类本身并没有改变。

你真的以为律师会消失吗?不会的。他们反而会处理更复杂、更专业化的案件;你觉得政治家会被 AI 取代吗?更不会,他们只会有更多平台来误导公众。现实就是这样。我们可以轻而易举地列出无数不会消失的职业,只不过它们的工作内容和方式将被彻底重塑。

真正的问题其实在于——我们的人口正在迅速老化,而年轻劳动力正变得稀缺。看看亚洲的生育率:两个父母只养一个孩子。这在经济结构上是不可持续的。所以,未来几十年,我们必须聚焦于一个核心议题:如何提升现有劳动力的生产力,尤其是年轻一代。因为正是这群人,要来支撑我们这些老年人。而我们这些人只会不断抱怨:" 为什么年轻人不能为我们提供更多服务?"

AI 将成为关键工具。许多研究指出,随着 AI 智能体规模化应用,尤其是在科研、商业流程自动化等方面,年均生产力增长可能达到 30%。这在历史上是前所未有的变化速度。

我与很多经济学家讨论过这一点。他们坦言,现有经济模型根本无法预测这种增长所带来的后果。如果我们能将 AI 用于正确的方向,这将是一次翻天覆地的进步机遇。

问:这确实令人难以置信。你亲历了几十年技术浪潮的更迭,如今又站在 AI 转型的风口浪尖。对于当下感到既兴奋又焦虑的技术人员、决策者和公众,你会给出怎样的忠告,帮助他们度过这个 " 疯狂 " 的时代?

施密特:首先要记住的核心一点是:这是一场马拉松,不是一场短跑。

我曾做过一件愚蠢但有意义的事——参加了一场 160 公里的自行车赛。虽然那是一个糟糕的决定,但它教会我一个重要的原则:节奏与持续性。你必须每天都前进一点,持续适应变化。

在谷歌的日子里,我们每年实现的增长和变革都多得惊人,以至于人们会忘记自己实际上已经走了多远。今天,我们正处在一条指数增长的技术曲线之中,而人类的大脑并不擅长理解这种非线性变化。

你会发现,短短两三年时间,整个世界就已经面目全非。而你的任务,是要学会每天驾驭这股浪潮。不能把这当成某个短期趋势或 " 阶段性事件 ",而要意识到它是一个长期演进的现实。

最重要的是:每个人都有理由去使用这项技术。无论你是艺术家、教师、医生、企业家还是工程师,如果你现在不主动采用 AI 工具,那么你将逐渐在你的领域中失去竞争力——无论是对比同龄人,还是对比全球市场。

采用它,越早越好。

我自己都被这些系统的速度震撼了。我的背景其实是企业级软件,现在看看 Anthropic 发布的 Protocol 模型,它可以直接接入数据库,不再依赖传统中间件。这意味着整个 " 中间件行业 " ——一个规模庞大的技术生态系统——可能将彻底消失。

你只需要 " 说出你想要的 ",系统就能理解、调取并返回结果。这只是商业变革的一个缩影,每天我们都能看到越来越多这样的例子。

(文 / 腾讯科技特约编译 金鹿)