英伟达 CUDA 重大更新!

Nvidia 发布了其CUDA 工具包的最新更新,Ver. 13 引入了重大的性能更新。

CUDA 13 版本特性概述

CUDA 13 版本引入了全新 CPU 资源支持、统一 Arm 平台架构,并新增了多个操作系统适配。

英伟达已发布 CUDA 工具包的最新更新版本,13 版本带来了显著的性能升级。

升级后的工具包增强了程序员使用便利性、兼容性及语言加速能力。13 版本还首次在英伟达生态中引入基于分块的编程模型,进一步降低开发者工作量。

什么是CUDA?

图形处理器(GPU)针对含多个小型处理核心的高度并行运算进行了优化,但其本身难以直接用于非图形计算场景的编程。CUDA 是英伟达开发的计算环境,支持图形渲染以外的高性能计算应用。该平台作为 GPU 与通用应用程序之间的中间层,可赋能需要并行运算的程序,同时包含丰富的库、编译器指令及语言适配功能。

AI 大语言模型开发与应用、科学分析及密码学等复杂场景,均能从 GPU 及多 GPU 系统提供的大规模并行计算中获益。CUDA 的设计目标即让广泛的应用开发者能够利用这些计算场景。

13 版本关键更新

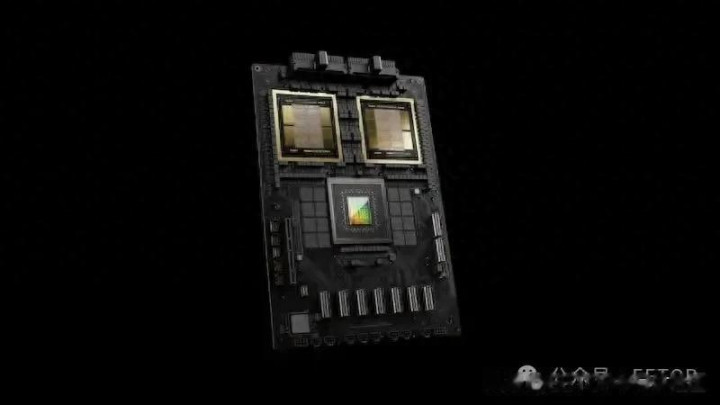

CUDA 13 新增对英伟达最新 Blackwell GPU、Jetson Thor 高级 AI 与机器人 GPU,以及 DGX Spark “桌面超级计算机” 的支持。其支持范围覆盖至当前所有架构的英伟达 GPU(不再支持 7.5 之前的架构),并针对 Blackwell 架构更新了 32 字节对齐的向量类型以提升性能。

该工具包统一了 Arm 平台的开发者体验,提供覆盖服务器与嵌入式应用的单一工具链,同时更新了操作系统与平台支持,包括红帽企业 Linux 10、Debian 12.10、Fedora 42,以及 Rocky Linux 10.0 和 9.6。此外,NVIDIA Nsight 开发工具得到更新以优化依赖检查,CUDA 数学库(如 cuBLAS、cuSPARSE、cuSOLVER 及 cuFFT)也完成升级。

NVCC 编译器现支持 GCC 15 与 Clang 20,并引入新语言特性以改善应用二进制接口(ABI)集成。用户还将获得加速的 Python 核心与开发者友好的封装方式,Wheel 包与 CUDA 核心计算库(CCCL)也优化了库结构。

统一服务器与嵌入式开发工具链

在 13 版本之前,CUDA 几乎可视为两个独立产品:开发者需分别安装服务器级项目与嵌入式项目的工具链。两者语法与操作虽高度相似,但针对服务器与嵌入式目标的库、头文件及其他开发组件存在差异。

13 版本打破了这一限制:现在单一工具链可同时适配两种目标场景,生成的二进制文件会针对开发者使用的 GPU 自动优化,无需因部署场景切换工具链。

新版本还整合了与 GPU 部署配套的 Arm 代码 ——Arm 二进制文件兼容所有 Arm 目标设备(仅 Orin sm_87 除外)及仿真平台,而旧版本需要为仿真与部署使用不同工具链。

基于分块的并行编程

分块编程(或基于数组的编程)支持对数组或矩阵中的所有数据点同时执行指令。并行编程常需对多个数据块同时执行相同操作,而分块编程可自动为开发者处理并行逻辑:只需编写单个函数,底层智能层会处理所有低级细节以实现并行运算。

编译器与运行时系统负责在线程与核心间分配负载,该抽象层在大幅降低编码负担的同时实现了性能最大化。

免费获取

英伟达 CUDA 工具包 13 版本现已开放免费下载,支持 Linux x86_64 与 arm64-sbsa 多发行版,以及 Windows 10、11、Server 2022 和 Server 2025 的 x86_64 平台。